电子发烧友网报道(文/梁浩斌)对于自动驾驶而言,除了自动驾驶算法之外,传感器标定一直都是一个难题,一般会在车辆出厂前驶入到专门的场地使用特定设备来对各种传感器进行校准。尤其是多传感器硬件下,激光雷达、摄像头、毫米波雷达等,由于各个传感器的位置不同,提供的数据也不同,所以包括数据融合,时间同步等问题。

最近在CES上,京瓷展示了一套独特的方案,似乎可以解决这些问题。

世界上第一个实现光轴对齐的摄像头+激光雷达融合传感器自动驾驶应用中,激光雷达和摄像头同时使用十分普遍,激光雷达能够提供长距离、高精度的3D环境感知信息,从而在复杂环境以高精度检测障碍物。但过去在自动驾驶应用中,激光雷达和摄像头都来自独立的模块,而独立模块的数据中由于部署位置不同,传感器的视察会导致传感器之间校准出现延迟。

来源:京瓷

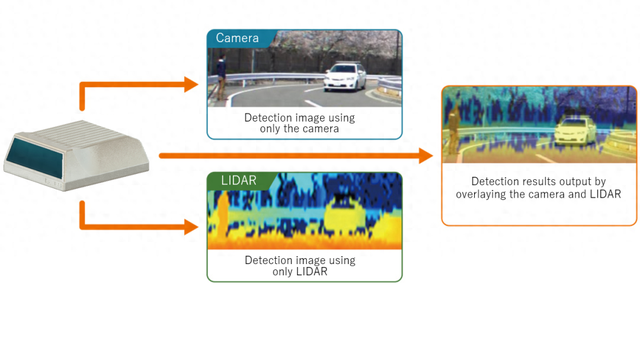

而京瓷推出的摄像头-激光雷达融合传感器,将摄像头和高分辨率激光雷达集成在一个单元中,用于无视差、实时数据融合,确保高效和准确的输出结果。

京瓷表示,这是世界上第一款将摄像头和激光雷达集成到一个光轴对齐的单元上的产品,这使得摄像头图像数据和激光雷达距离数据的实时融合,可以实现迄今为止最先进的物体识别能力。

光轴即光学系统中光线传播的中心线,通常是透镜或反射镜的对称轴。光轴对齐一个常见应用就是手机摄像头中,镜头的多个镜片和CMOS图像传感器中心对齐,避免像差、失真或光损失。

但对于一个多传感器融合的系统而言,就会给光轴对准带来了极高的难度。首先激光雷达通过发射激光束并接收反射回来的信号来测量距离,生成点云数据;而摄像头则捕捉环境的二维图像。这两种传感器的数据格式不同,坐标系也不同,使得直接对齐它们的光轴变得极为复杂。

京瓷的这款产品结构,是将前置激光雷达获得图像的光轴,与放置在激光雷达前方的摄像头的半反射镜进行对齐,也就是说通过半反射镜,实现两个传感器的光轴对齐。即使用这个摄像头-激光雷达融合传感器模块后,无需再在两个传感器之间进行校准工作,将原本后端处理的传感器信息融合,转移到了传感器端,将无视差的数据在传感器硬件端就实现了融合叠加。

一般激光雷达会使用MEMS振镜或是电机进行扫描,但采用MEMS振镜的激光雷达分辨率较低,而电机又容易出现磨损。基于京瓷在陶瓷封装和半导体制造技术上的优势,该激光雷达可以提供更高分辨率的同时,也能够实现更强的耐用性。

京瓷摄像头-激光雷达融合传感器最终可以实现高达0.045°的角分辨率,可以在100米距离远处掉落的30cm大小物体。

不过,由于采用半反射镜会对进入传感器的光线造成难以避免的衰减,所以这款融合传感器在京瓷的规划中分为两个规格,分别是测距60m-100m,视场角100°×24°;测距120m-200m,视场角缩小至50°×15°。

“二合一传感器”会成为自动驾驶趋势吗?将数据融合,从后端的算力芯片转移到光学层面和传感器端,对于自动驾驶而言无疑具有重要意义。

在感知的准确性上,当不同类型的传感器能够精确对齐时,它们提供的数据可以在同一坐标系下进行融合。这意味着可以更准确地识别和定位环境中的物体,从而提高车辆对周围环境的理解能力。

过去在一些支持纯视觉自动驾驶方案的观点中能够看到,多传感器会导致系统决策出现困难,比如当两个传感器获取到的信息不一致,应该相信哪一个?那么将激光雷达和摄像头进行光轴对齐后的融合传感器中,输出到后端算力系统中的数据就变成了深度和视觉图像的融合数据,对于自动驾驶系统决策也能够提供更可靠的信息。基于更准确、更全面的环境信息,自动驾驶系统的决策模块可以做出更加合理和安全的驾驶决策。

同时,有业内人士表示,激光雷达和摄像头实现光轴对齐后,对自动驾驶标定会产生很大帮助。由于目前图像-点云融合在大多数情况下只能够做到语义级别的后端融合,没有发挥两种传感器互补的优势。如果能够以低成本实现光轴对齐,两种传感器数据实现像素级融合,那么前端融合算法可能会迎来新一轮发展。

小结根据京瓷官方的说法,摄像头-激光雷达融合传感器计划在2027年实现商业化,目前市面上确实还未看到有其他厂商推出这类产品,印象中,几年前小编在与一些激光雷达厂商交流时,也有人提到过相似的概念,但当时也只是对激光雷达未来发展路线的一种设想。到底这类产品在实际应用中能够给自动驾驶带来多大的收益,或许要看接下来会不会有其他厂商尝试跟进了。