声明:本文陈述所有内容皆有可靠信息来源赘述在文章结尾。

文丨小橘nono

编辑丨小橘nono

前言人们常说“眼见为实,耳听为虚”,可有些时候,亲眼看到的也不一定是真的。

骗子们只需要一张照片,就能够进行AI换脸,冒充你最亲近的人实施诈骗手段。

这种诈骗手段的成功率高达100%,所以一定要对这件事情提高警惕,保护好自己和家人的安全。

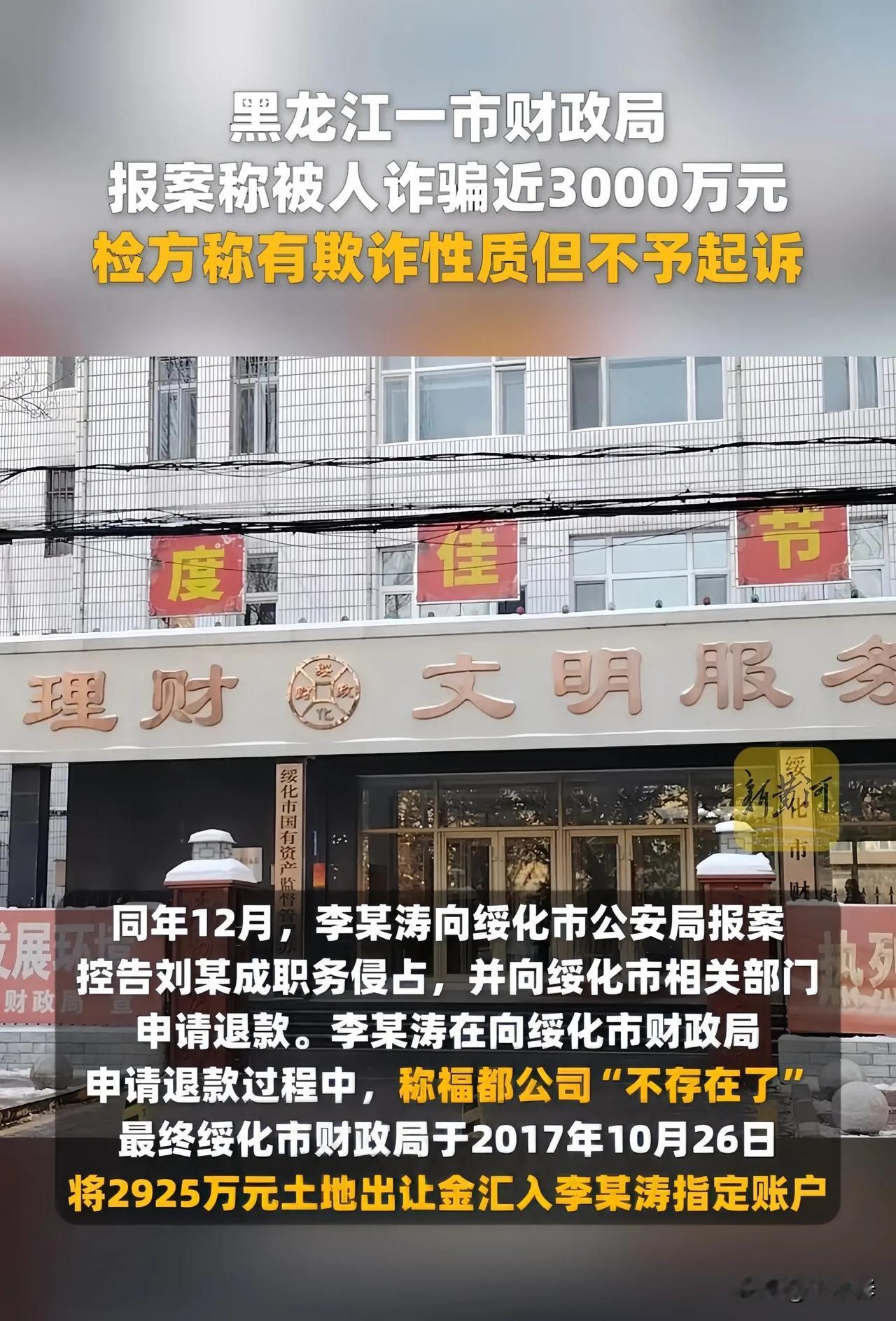

AI诈骗AI诈骗的触角,已经从公众人物延伸至普通民众,其危害性日益加剧。我们先来看一些触目惊心的案例。

2023年5月,福州一位公司法人代表郭先生,就遭遇了一场精心策划的AI诈骗。他接到了一位“朋友”的微信视频电话,对方不仅容貌与声音都和他的朋友一模一样,甚至还展示了所谓的竞标现场。

郭先生信以为真,将430万元转入对方提供的账户,短短10分钟内就损失惨重。事后才发现,这通视频电话完全是骗子利用AI技术伪造的。

另一个更常见的案例是,骗子冒充熟人,通过视频通话要求转账,由于其逼真程度极高,成功率几乎达到100%。尤其对于辨别能力较弱的老年人来说,AI合成的声音更是难以分辨,他们更容易落入骗子的圈套。

北京日报的调查显示,参与测试的10位老人都无法准确分辨真人语音和AI合成语音,甚至听到自己家人的AI合成声音,也毫不怀疑地认为是真人。

这些案例仅仅是冰山一角,它们揭示了一个残酷的现实:AI诈骗已经渗透到我们生活的方方面面,任何人都可能成为受害者。

AI诈骗的技术手段AI诈骗之所以如此猖獗,与其背后精密的技术手段密不可分。然而,再高明的技术也并非无懈可击,了解这些技术手段及其漏洞,有助于我们提高警惕,识别骗局。

AI换脸技术是AI诈骗的核心手段之一。它可以实时替换人脸,模仿任何人的面部表情和动作,进行视频通话。

AI拟声技术则可以模仿任何人的声音,进行语音通话,其逼真程度足以以假乱真。此外,AI还可以生成带有时间、地点等细节的假新闻,并迅速传播,让人难以分辨真假。这些技术手段的结合,使得AI诈骗更加难以防范。

尽管AI技术日新月异,但其生成的视频和语音并非完美无缺。仔细观察,仍能发现一些蛛丝马迹。

例如,在视频通话中,伪造人物的眼睛和瞳孔细节往往不一致,嘴部动作也无法完全匹配语音。

视频的分辨率也可能存在问题,人物的牙齿边缘过于整齐,画质明显低于原始视频。此外,AI生成的动态画面在快速抬头、转头等动作时,容易出现画面抖动或不连贯的现象。

了解这些技术漏洞,可以帮助我们识别AI诈骗。然而,仅仅依靠肉眼观察仍然存在局限性,因为这些漏洞往往非常细微,不易察觉。

特别是对于不熟悉AI技术的人来说,更难以识别。因此,我们需要采取更有效的防范措施。

AI诈骗的危害是多方面的,其影响远超出了单纯的经济损失。这是最直接的危害。受害者往往被骗取巨额钱财,轻则损失积蓄,重则倾家荡产。

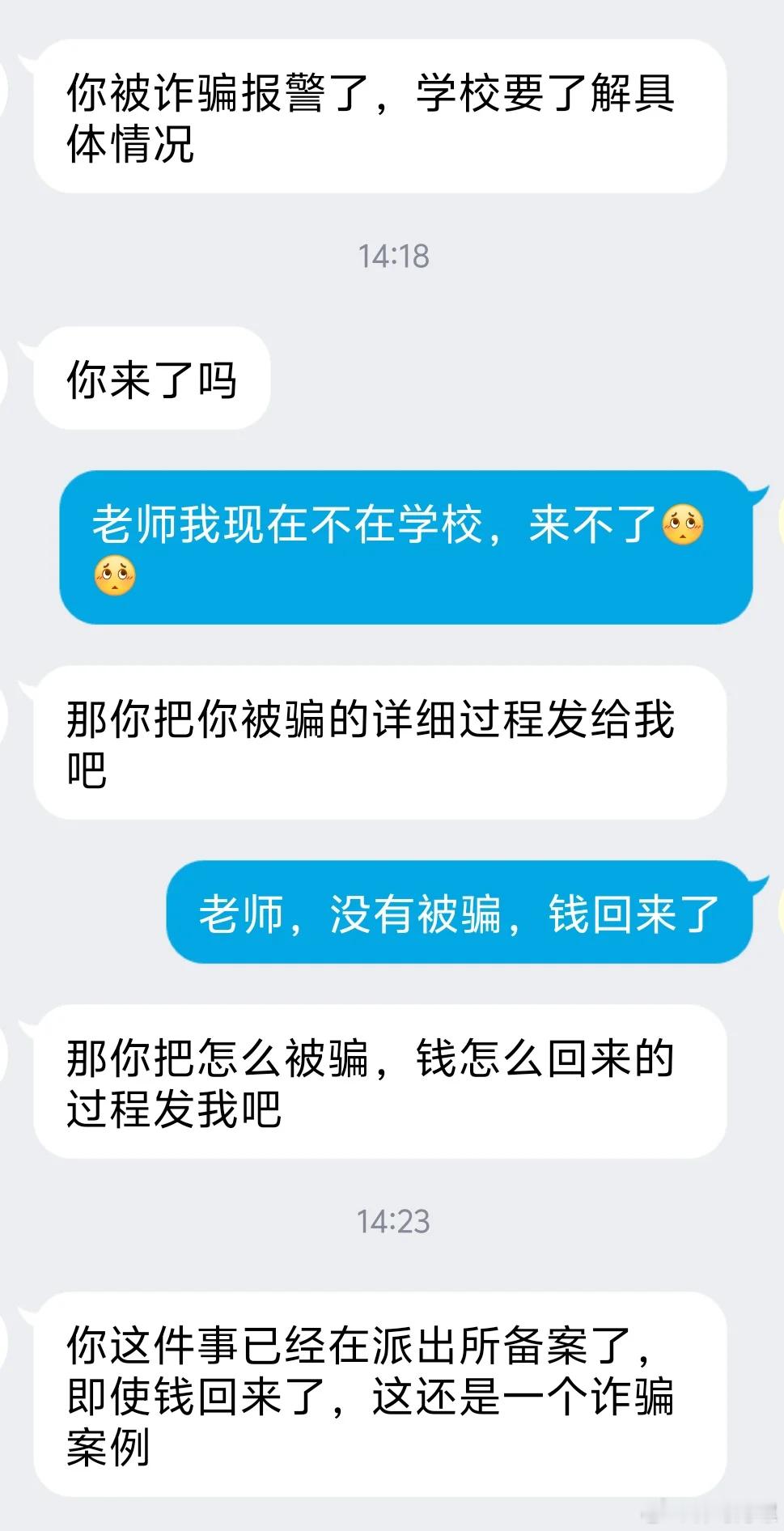

如何防范AI诈骗接到亲友借钱请求时,不要轻信视频或语音通话,务必通过电话、当面等其他方式进行多重验证,确认对方的身份。

在视频通话中,仔细观察对方的面部表情、眼神、嘴部动作是否自然,声音与口型是否一致,画面是否存在抖动、模糊等异常情况。

避免在社交媒体上公开发布包含敏感信息的的照片或视频,特别是涉及人脸、指纹等生物特征的数据。

对陌生电话、链接、二维码保持警惕,不轻易点击或扫描,不轻易透露个人信息,包括姓名、身份证号、银行卡号、密码等。

如果一旦发现被骗,要及时报警,并保留相关证据,以便警方开展调查。

防范AI诈骗,需要个人、社会、政府、企业多方共同努力。作为个人,我们要提高警惕,加强学习,保护好自己的信息安全;作为社会,我们要加强宣传教育,营造良好的网络安全环境。

政府要完善法律法规,加大打击力度。作为企业,我们要承担社会责任,加强技术研发,防止技术滥用。

只有各方携手合作,才能有效应对AI诈骗带来的挑战,构建安全可靠的网络环境,守护每个人的安全,让科技真正造福人类。让我们共同努力,让科技之光照亮未来,而不是被黑暗所吞噬。

结语AI技术的进步是不可逆的,它本应为人类带来福祉,而不应该成为我们安全生活的威胁。AI技术是一把双刃剑,关键在于如何使用它。

我们应该引导科技向善,让AI技术更好地服务于人类,而不是被滥用为犯罪工具。

信息源:“眼见不一定为实”!警惕AI换脸、智能变声等新型诈骗手段,大众日报2024-12-13。

【免责声明】文章描述过程、图片都来源于网络,此文章旨在倡导社会正能量,无低俗等不良引导。如涉及版权或者人物侵权问题,请及时联系我们,我们将第一时间删除内容!如有事件存疑部分,联系后即刻删除或作出更改。