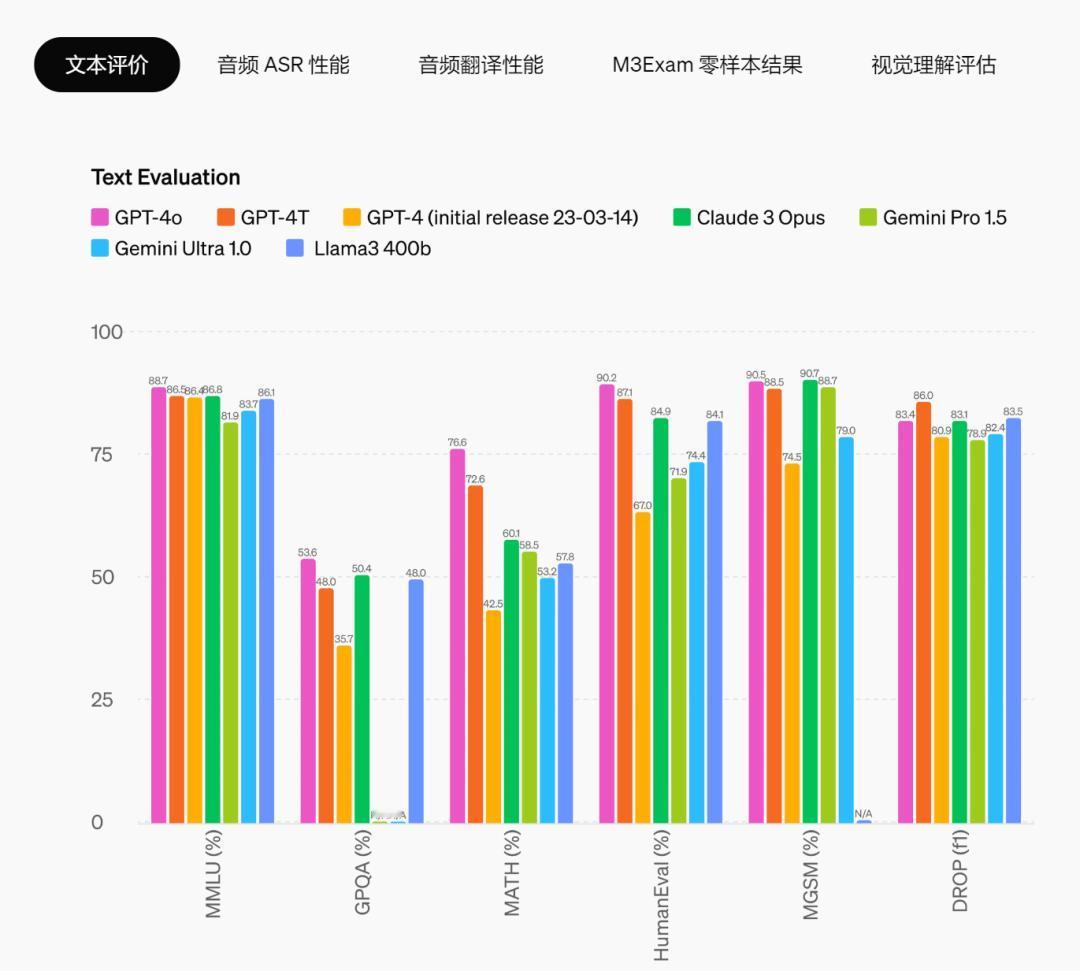

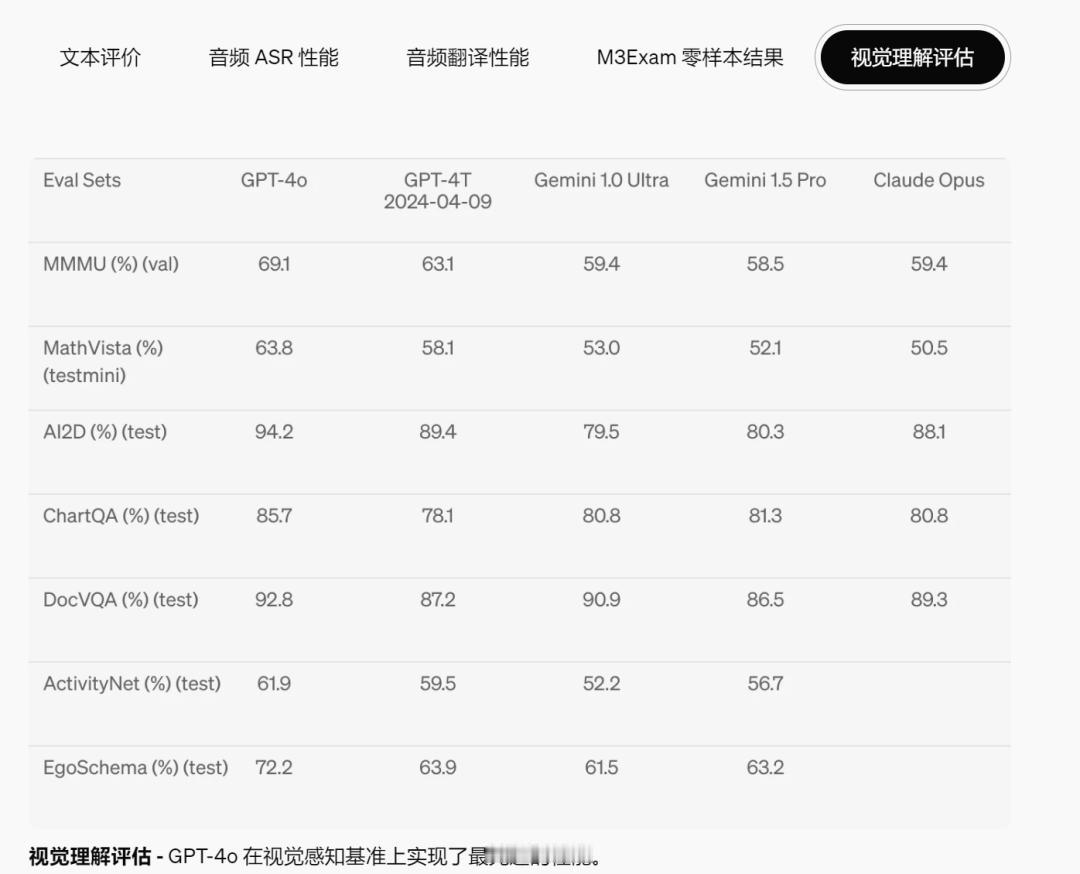

【her is coming ! ChatGPT-4o正式发布】 今天凌晨,OpenAI 用一场春季发布会,再次搅动了整个 AI 行业。 旗下最新多模态旗舰大模型GPT-4o正式发布,其中的「o」代表「omni」(即全面、全能的意思),这次亮相的GPT-4o不仅仅是一个语音助手,更是一个变身人类的超级助理。 本次GPT-4o升级最大的地方是:【音频、多语言和视觉】 GPT-4o将跨文本、视觉和音频端到端地训练了一个新模型,这意味着所有输入和输出都由同一神经网络处理。 比如:在响应速度方面,GPT-4o 几乎解决了延迟问题。GPT-4o的响应音频输入的最短时长为232毫秒,平均响应时长320毫秒,几乎与人类相似。 没有使用GPT-4o的ChatGPT语音对话功能平均延迟为2.8秒 (GPT-3.5) 和5.4秒(GPT-4)。而在视觉理解评估上,GPT-4o 在视觉感知基准上都实现了最先进的性能。 除此之外,情绪感知是此次更新的另一大亮点。 比如:GPT-4o 根据要求调整说话时语气,GPT-4o 可以根据指令改变声音,从夸张戏剧到冰冷机械,展现了出色的可塑性。同时,GPT-4o 不仅能够识别用户的情绪,还能在对话中适时提出建议。这也让GPT-4o 能够更贴近用户需求,提供更具针对性的帮助和支持。 其实这次GPT-4o给人的整体感觉是: 几乎无延迟的相应、聪明、有趣、且实用,它的出现也让人机交互变得更接近人与人间的自然交流。 最让人惊喜的是,新模型GPT-4o不再由付费用户独享,将免费提供给所有用户使用。#chat GPT#