#大模型下一站是去AI味儿#

大模型的「幻觉」问题,其实是被很多用户所忽略的问题,它实际上是一种大模型对于问题输入的「不理解」、「误解」或「选择性忽视」,从而导致输出结果的偏差,背离了基本的现实,但在大模型的角度,他认为自己的运行链路是没有问题的,是顺畅的,所以这一现象很常见,也很难解决。

能够处理好幻觉问题,实际上代表了有能力在代码和控制层面对于大模型形成精准的把控,拟人性相比于普通的产品上升好几个维度,真正做到像人一样思考和产出。这算是一道分水岭,也是辨别产品成熟度的关键指标。iRAG算是一个比较成熟的代表。

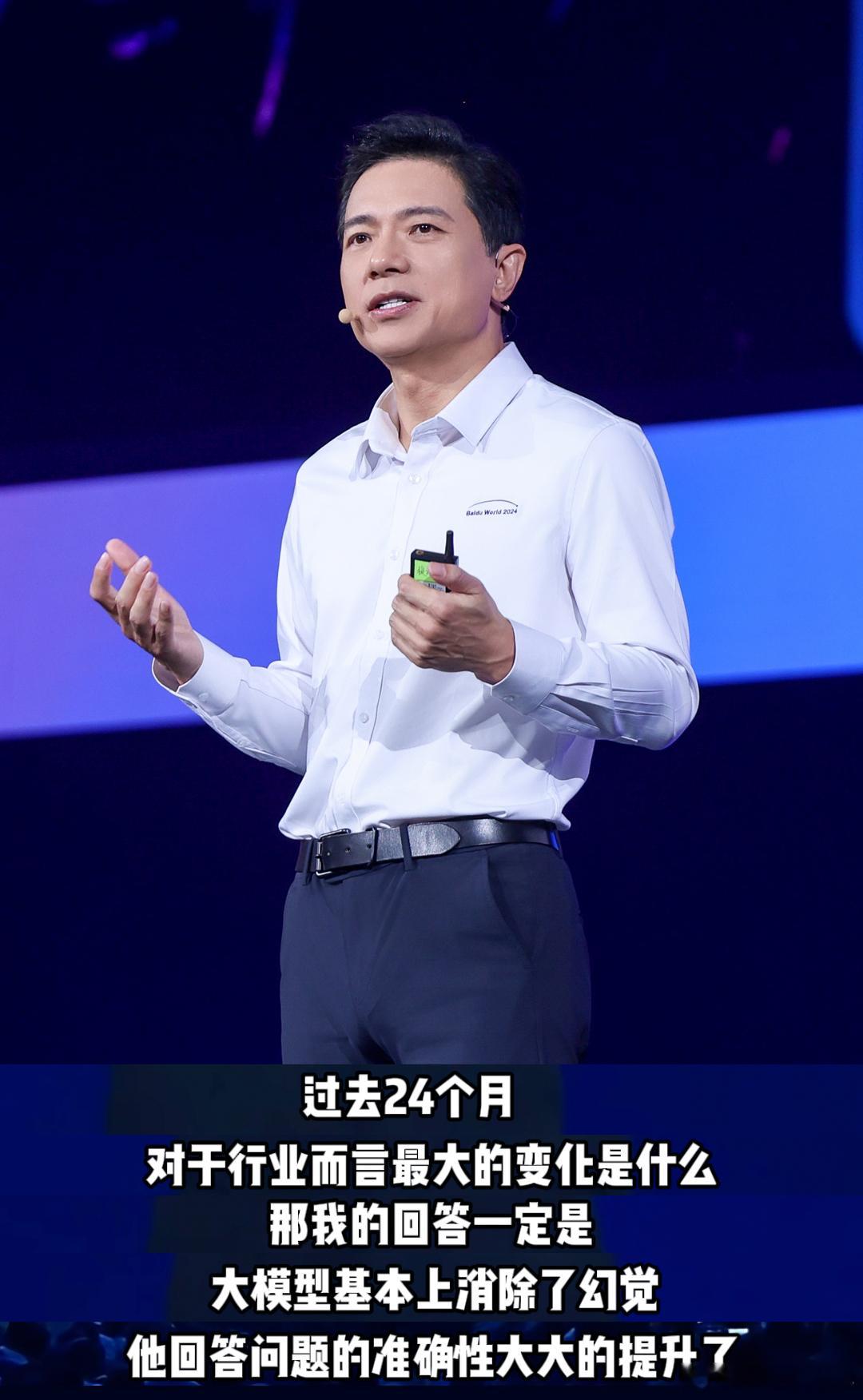

#过去2年大模型已基本消除幻觉#