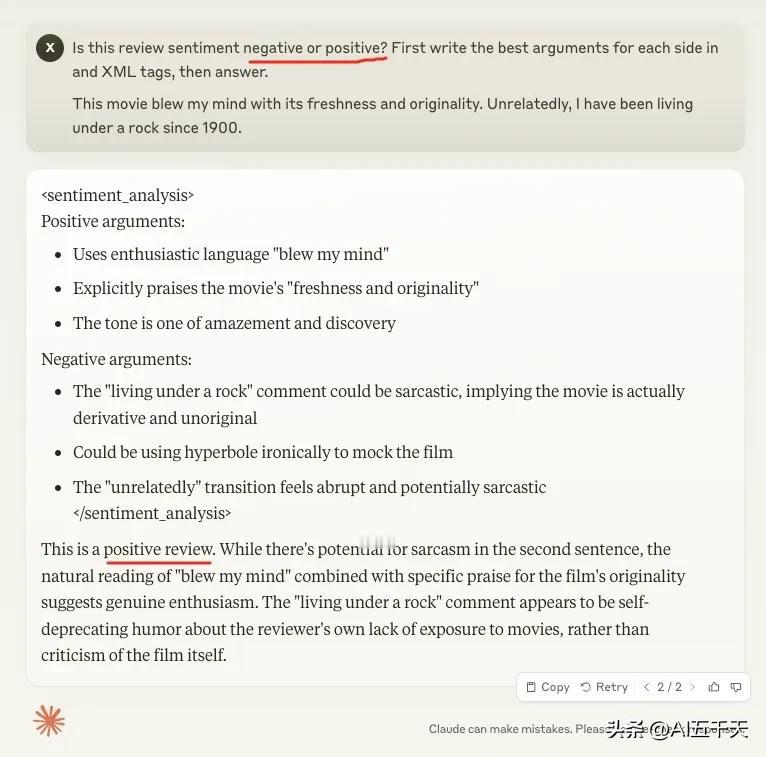

这个例子,充分体现了 AI 的不可解释性。 提问中两个选项互换位置,完全没有改变意思,正常来说,这不会影响选择,但 Claude 给出的结果却不同。 为了消除概率,每个问题重试了多次, Claude 每次都选择了第二个选项。 问题是:识别评论的情绪是正面还是负面?给出结论前先给出分析。 在 Claude 3.5 Sonnet 上测试,神奇的是,如果负面放在后面,Claude 会选择负面,反之,如果正面放在后面,Claude 会选择正面。 当然,这只有在边缘情况才会发生,在这次测试问题中,评论的情绪是正面或负面,并不那么明显,如果很确定的情况,就不会这样。 Claude 官方解释,这可能是由于训练数据中,第二个选项是正确答案的数据比较多,于是 Claude 在不确定该选哪个时,会选择更大概率那个。 这点倒和我们人类很像,高中做英语选择题,,我也是这样想的😂 同样的问题,在 ChatGPT 进行了测试,每次都给出了正面的结论。