「学习笔记:大语言模型的幻觉」

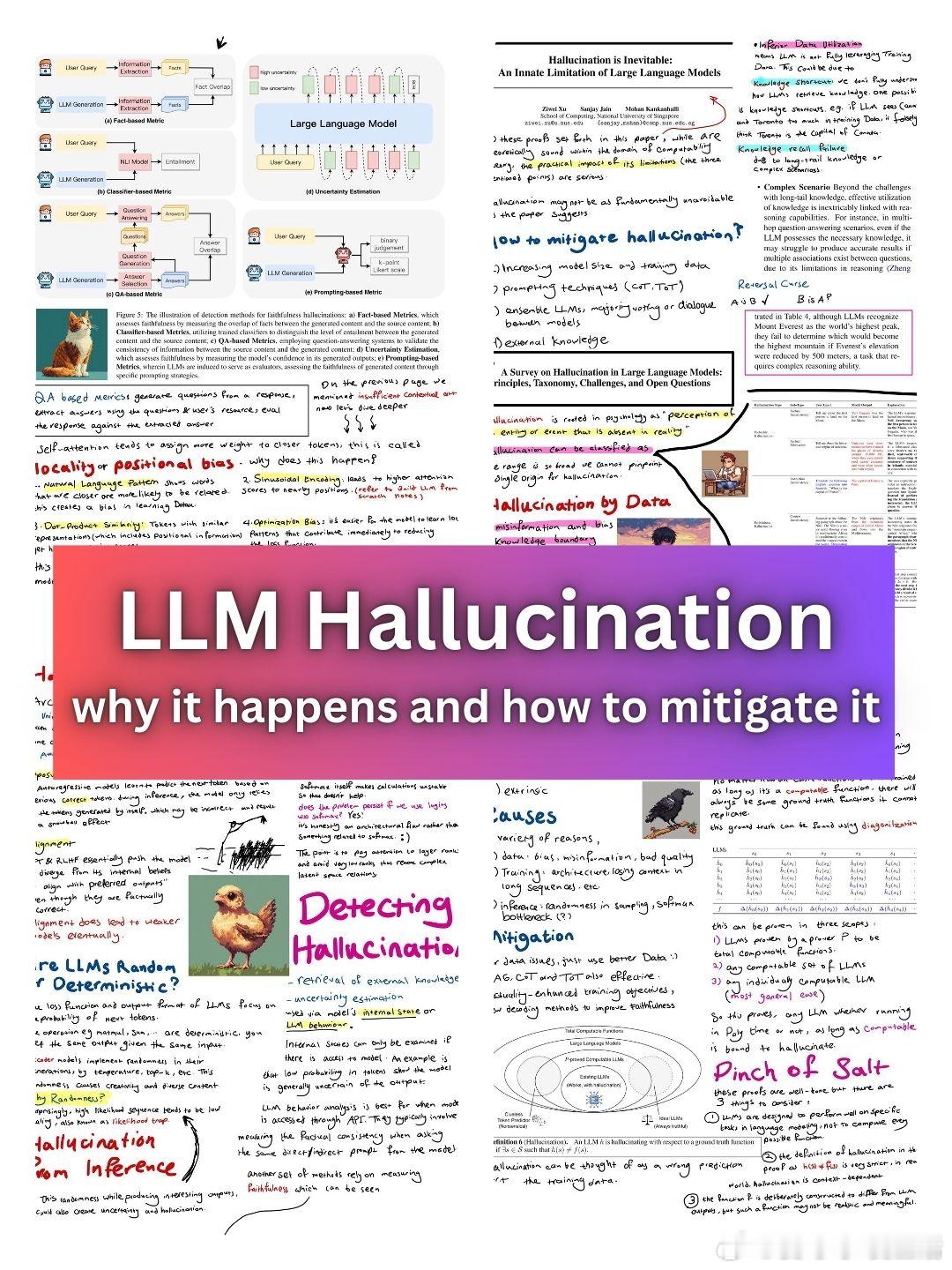

LLM的“幻觉”,这个看似简单的AI行为背后,其实暗藏着复杂的技术难题和深刻的认知挑战。

首先,LLM幻觉并非偶然,而是AI模型本质特性导致的必然结果。它源于模型在处理和整合海量信息时的不确定性。想象一下,就像我们人类在快速处理大量信息时也会产生错觉一样。

解决方案可以从四个维度入手:

1. 扩大模型规模,提升数据质量

2. 优化提示技术(如CoT、ToT等)

3. 增强LLM架构设计

4. 深化领域知识的融入

特别值得注意的是“检测幻觉”这个关键环节。需要建立起严谨的评估体系,就像给模型装上一个“真实性探测器”。这不仅涉及技术层面的创新,更需要我们在认知科学层面的突破。

事实上,LLM的幻觉问题揭示了一个更深层的议题:在追求AI进步的同时,如何保持其输出的可靠性与真实性。这需要技术与认知的双重突破,就像在精确的科学实验中加入一颗“盐”——既要保持严谨,又要有创新的空间。

GitHub:github.com/hesamsheikh/ml-retreat/blob/main/assets/LLM-Hallucination.pdf