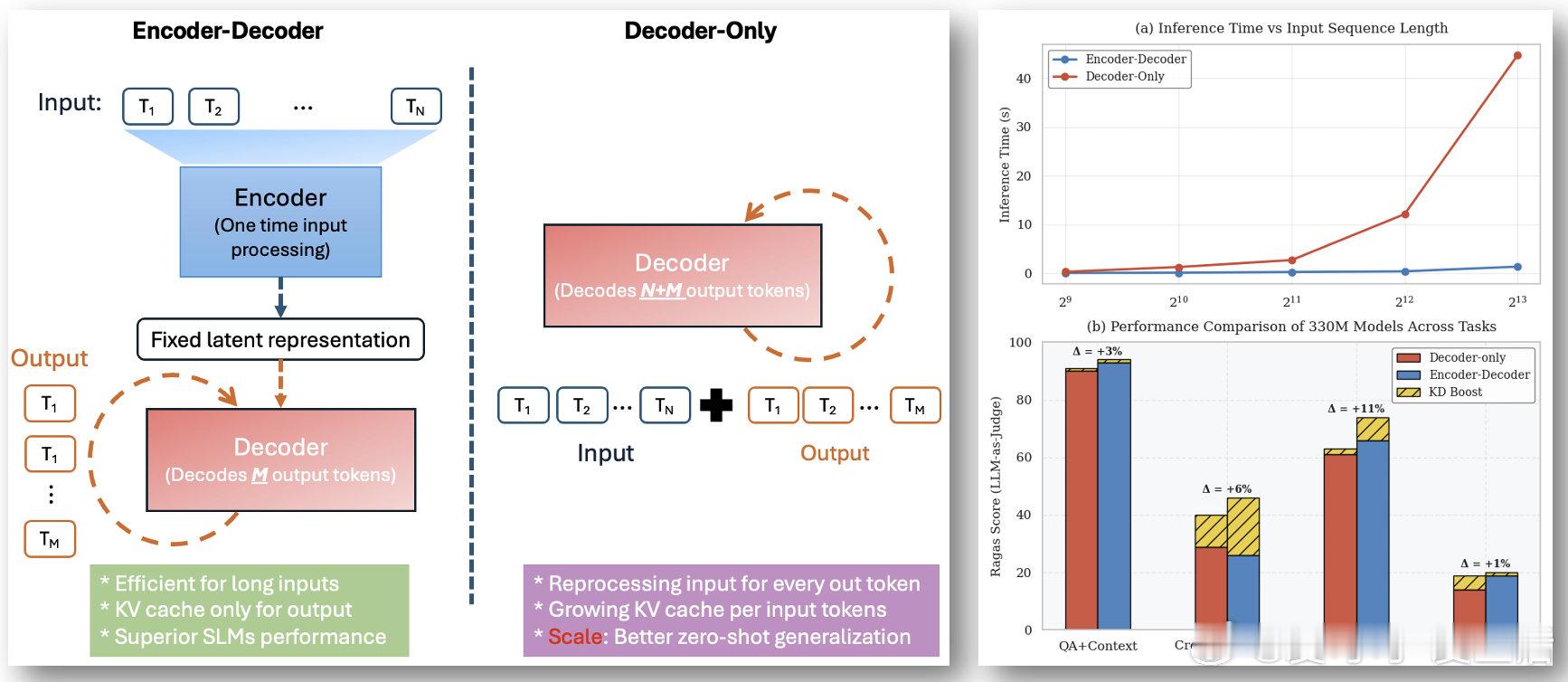

【[15星]Encoder-Decoder-SLM:微软推出的高效小语言模型架构,专为10亿参数以下的模型设计,助力小模型在性能和效率上赶超大模型!亮点:1. 性能提升显著,基础架构提升2-4%,知识蒸馏后提升6-8%;2. 推理效率极高,首token延迟降低47%,边缘设备吞吐量提升4.7倍;3. 内存和计算成本大幅降低,内存减少11-16%,FLOPs减少22%】

'Efficient encoder-decoder architecture for small language models (≤1B parameters) with cross-architecture knowledge distillation and vision-language capabilities'

GitHub: github.com/microsoft/encoder-decoder-slm