《科创板日报》2月6日讯(记者毛明江黄心怡)今日一则关于人工智能领域的新闻引发广泛关注。

据报道,李飞飞等斯坦福大学和华盛顿大学的研究人员以不到50美元的云计算费用,成功训练出了一个名为s1的人工智能推理模型。该模型在数学和编码能力测试中的表现,据称与OpenAI的O1和DeepSeek的R1等尖端推理模型不相上下。

这一消息无疑在AI界投下了一颗重磅炸弹,真相究竟如何?

《科创板日报》记者调查和采访业内人士后发现,s1模型的训练并非从零开始,而是基于阿里云通义千问(Qwen)模型进行监督微调。这意味着,s1模型的神奇“低成本”,是建立在已具备强大能力的开源基础模型之上。

通义模型的“基座”作用

根据李飞飞等人的研究论文,s1模型的训练仅使用了1000个样本数据。按照业内共识,这一数据量在AI训练中可谓微乎其微,通常不足以训练出一个具备推理能力的模型。

青年AI科学家、上海交通大学人工智能学院谢伟迪副教授告诉《科创板日报》记者,如果仔细研究斯坦福s1的论文会发现,s1模型的神奇是以通义千问模型为基座进行微调,这1000个样本训练的作用更像是“锦上添花”,而非“从零开始”。

国内某知名大模型公司CEO也向《科创板日报》记者表示:“从论文原文来看,所谓用50美元训练出新的具有推理能力的模型,实际上只是用从谷歌模型中提炼出来的1000个样本,然后对通义千问模型进行监督微调。这种微调的成本确实很低,但明显是站在既有领先模型的‘肩上’才能做到。”

###斯坦福s1论文原文也注明模型是以阿里通义千问模型为基础微调

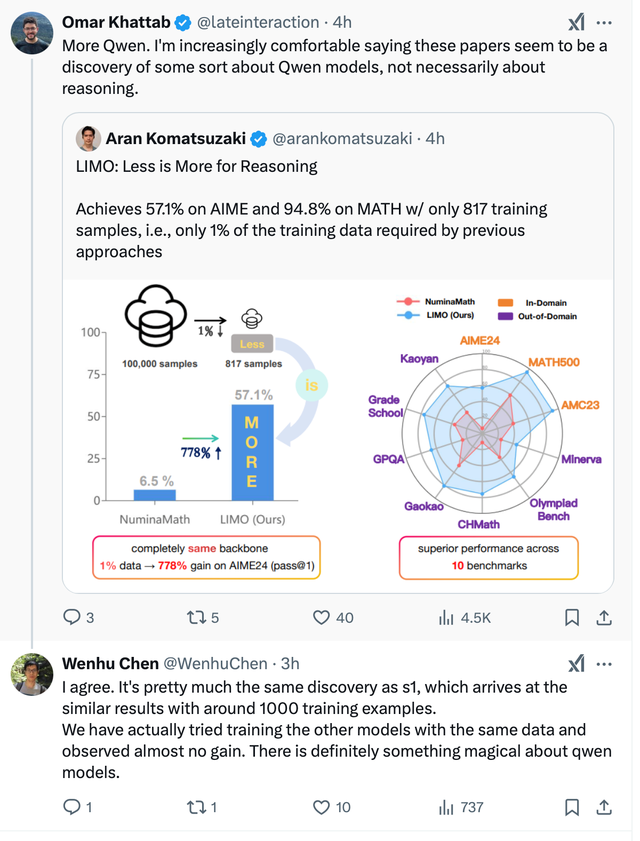

谢伟迪指出,国内外还有其他团队也声称用极低的成本,训练出了具有推理能力的新模型。但一阅读其论文原文,就会发现它们无一例外都是基于通义模型作为基座进行的。

###国外多位人工智能研究者也指出,不少的“新”模型都是建立通义模型基础上

“以通义千问模型作为基座,确实可以用很少的样本数据就达到产生新的推理模型的效果,但如果换成其他基座模型,新模型能力却没有任何的提升。所以,能力真正神奇的是Qwen模型,而不是s1。”谢伟迪说。

低成本训练大模型有局限,但也是方向

尽管s1模型的低成本训练在某种程度上展示了AI训练的潜力,但其局限性也不容忽视。

首先,这种低成本训练依赖于已有的强大基座模型,如阿里通义千问模型。如果没有这样的基座模型,低成本训练的效果将大打折扣。

其次,1000个样本数据的训练量在大多数情况下是不够的,尤其是在需要处理复杂任务的场景中。

此外,低成本训练的成功也引发了对AI模型知识产权和伦理问题的讨论。如果越来越多的研究依赖于已有的基座模型进行微调,那么这些基座模型的开发者是否应该获得相应的回报?如何确保AI技术的公平使用和共享?这些问题都需要业界进一步探讨和解决。

尽管s1模型的低成本训练引发了争议,但其背后的研究思路无疑为AI领域提供了新的思考方向。

武汉人工智能学院一位资深研究人员向《科创板日报》记者表示,如何在保证模型性能的前提下,降低训练成本,是AI研究的一个重要课题。未来,随着技术的进步和算法的优化,或许我们真的能够看到更多低成本、高性能的AI模型问世。

(科创板日报记者黄心怡)

阿里:虽然我花了钱,但是我不说

三国靓仔

标题党

XX

难怪都说站在巨人肩膀上,原来这个巨人是阿里云Qwen模型

cowgirl3344

来互相拆台,互相伤害[得瑟][得瑟][得瑟]

元嘉嘉嘉

国外团队一个个为博人眼球,拿别人的内裤当头巾出来当现世宝,混淆视听,球创新没有,真裸奔没底裤!

用户17xxx38

其实现有大模型已经把网络知识库全部学完了,就算增加再多算力,知识库就只有这么多。更重要就是微调了

用户10xxx37

有人说中国ai落后国外多少年,DS好像突然冒出来的,让全世界惊讶于它的先进,可能吗?它是中国人工智能经过很多年发展的必然产物,以后这种现象会越来越多

渔莉

只要是计算机程序软件,就没有复杂的。一个有能力的程序员就可以完成所谓的大模型。

用户12xxx24 回复 渔莉 02-08 08:52

逗逼 数据加运行代码才构成程序 你怎么学的计算机

渔莉 回复 02-07 23:05

在计算机里实现模型不用程序用什么?难不成用手工去统计?

Cl_Smoothcrew

给阿里巴巴费用了吗

冲冠

李飞飞,中国人?

岁寒三友-洺 回复 02-07 21:33

不知道,但绝对是黄种人。现在基本上所有的尖端技术领域都是黄种人在带领团队,白人黑人都赶不上。[得瑟]

用户14xxx95

那还要那么多显卡搞毛线啊。英伟达哭晕在厕所里[笑着哭]

用户12xxx24

这不叫训练 这是微调