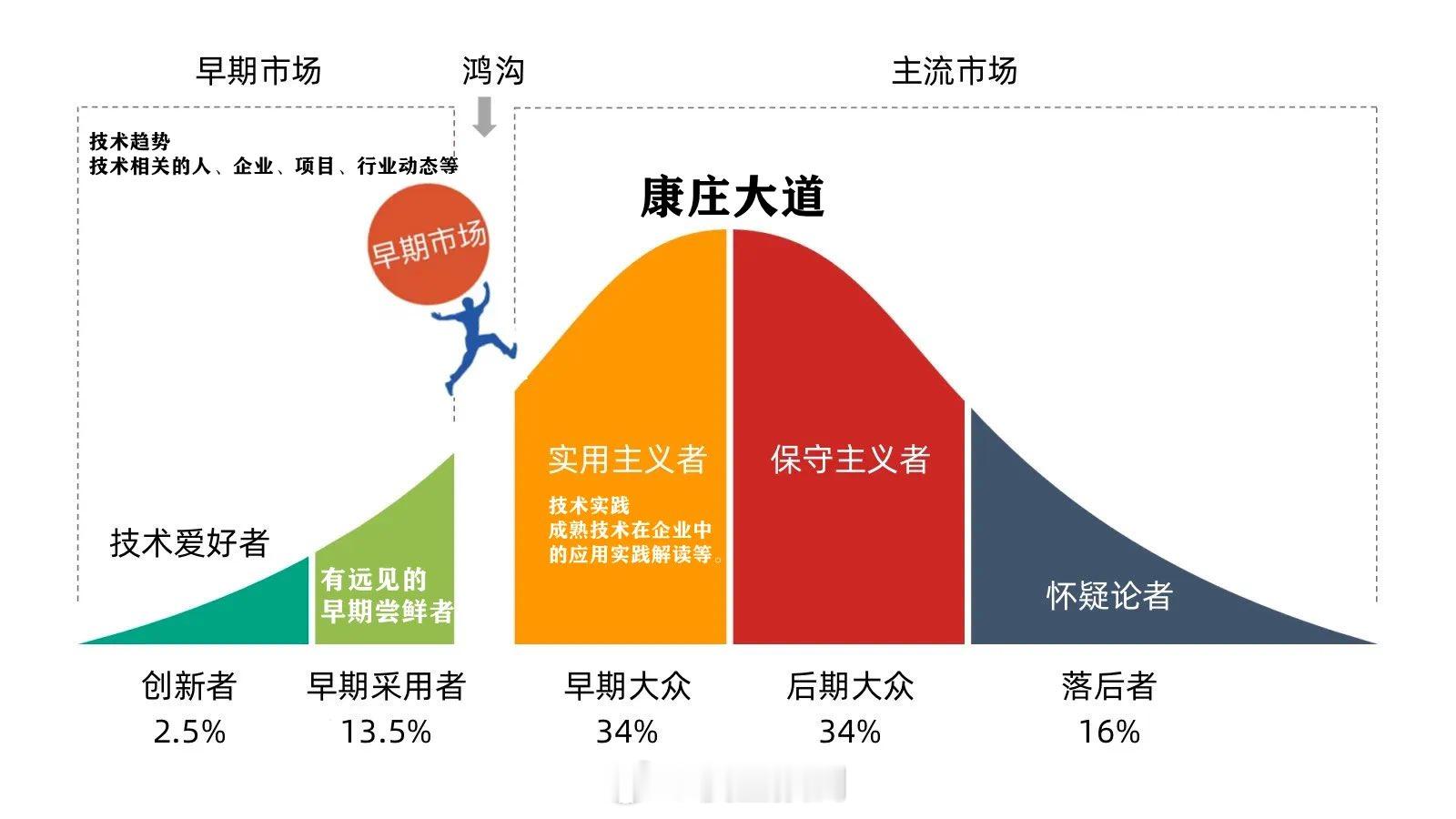

大模型引领的人工智能热潮在2024年持续发酵,整个AI领域的技术革新在算力、算法、token数、参数量这几个词的牵引下不停迭代、推陈出新,业界在不到半年里仿佛进入了“子弹时间”,既短暂,又漫长。人工智能正经历膨胀时期,但与此同时,有一件事却令整个业界为之焦虑,那就是能源短缺。

一篇发表在《Joule》杂志上的论文预测,到2027年,全球人工智能产业的年电力消耗将达到85.4至134太瓦时(TWH),这个数字大约等于荷兰、瑞典或阿根廷等国家一年的总用电量,也约占全球总电力消耗的0.5%。研究还发现,当下流行的生成式人工智能ChatGPT每天需处理约2亿次请求,这一过程的电力消耗超过50万千瓦时,相当于1.7万户美国家庭的日用电量。在2024年博世互联世界大会上,埃隆·马斯克警告说,人工智能和电动汽车的快速增长可能会导致全球电力和变压器供应短缺。同时,OpenAI的首席执行官萨姆·奥尔特曼在达沃斯世界经济论坛上表示,人工智能行业正面临能源危机,新一代生成式AI的能源需求显然超出预期,现有的能源供应将疲于应对。一时间,漫天飞来的AI能源危机论遍布全球。

● AI膨胀引发的能源危机从何而来?

当前,大型AI模型的发展势头迅猛,它们能够处理和学习庞大的数据集。这一能力背后需要巨大的计算资源支持,而这些资源通常由高性能处理器提供,包括GPU、TPU和ASIC芯片等。这些处理器需要大量的电力来驱动数据中心的服务器、存储设备和冷却系统。而以GPT为代表的生成式预训练大型语言模型,其计算需求正向依赖参数量和token数两个变量,极大影响着模型的潜在规模和复杂程度。参数量从十亿级到万亿级的指数变化,仅仅用了3年时间。

自2012年以来,AI训练应用的电力需求每3到4个月就会翻一倍。训练大模型需要大量的能源,AI服务器相较于传统服务器通常需要更高功率密度的硬件,例如AI服务器可能需要4颗1800W的高功率电源,而通用型服务器可能只需要2颗800W的电源。

另外硬件方面,如同谷歌人工智能专有部署TPU张量处理器,英伟达的H100和A100是当下业内主流人工智能算力卡,因其强大的FP16/32计算能力而广泛用于AI模型的训练和推理,但这些芯片的峰值功耗很高,例如H100的峰值功耗可达700瓦,远超过普通家庭的平均功耗。而GPT-4级别根据估算需要在1万—2.5万张H100上训练,保守估计也要8000张H100有效算力,接近万卡集群。随着大量H100被部署,其总功耗相当于一座大城市的能耗,甚至超过一些欧洲小国。

由于算力扩张带来的AI基础设施增长仍在持续放大,有消息称,根据去年市场H100卡总需求43万张,预计英伟达2024年将H100出货量至少增加两倍。而全球GPU产能大概约400万片,至2025年将提高到600多万片,每年复合增速不低于30%,再往后算,预计能源短缺很快将至从而引发产能瓶颈,整个AI领域和相关市场亦将回归“冷静”。

● 算力能耗的解药又在何处?

解决问题的首要方案是优化大模型,这不仅是行业各方的可行选择,也是力所能及的实施策略。一种是通过模型的缩减来避免不必要的浪费,譬如并非所有公司都需要GPT-4大模型,而从头训练一个GPT-3.5应该用不到太多H100算力卡;再比如,用达成Sora不到十分之一的算力资源来训练一个能够契合60%相关场景的更有效模型。这要求简化模型复杂度,减少不必要的层和结构,或者通过参数共享减少模型的总参数量。同时,可以选择使用更高效的神经网络架构,如卷积神经网络(CNN)代替全连接神经网络(FCN),以降低训练时的计算量。

另一方面,由于算力瓶颈的存在,在传统摩尔定律难以为继的背景下找到全新范式。学习率是优化算法中的关键超参数,调整学习率可以加速模型的收敛过程。同时使用正则化方法可以防止模型过拟合,提高泛化能力,也有助于减少计算量。在大模型中,由于参数量级庞大,梯度下降法的计算可能变得复杂。因此,需要适当选择诸如随机梯度下降和批量梯度下降等,根据具体情况进行调整。此外,模型压缩、数据预处理和增强、高效数据加载和预处理等都是通过算法优化来降低功耗的有效手段。

硬件方面的努力反映了另一种观点,那就是相信摩尔定律还在以新的方式继续。比如英伟达的黄仁勋在提数据中心的摩尔定律,把整个数据中心变成一个超级芯片,这使得现代人工智能超级计算机成为可能。最后效率是不是更高,芯片的能耗级是不是更优,都还有待验证。针对特定的人工智能场景任务,也可使用硬件加速器,如FPGA或ASIC来替代传统GPU执行计算。这些加速器专为特定任务设计,通常具有更高的能效比。

此外,优化电源管理方案、改进电路设计都是很好的节能思路。新型电源管理技术,如功耗管理单元(PMU)和智能电源管理芯片,能够根据实际需求动态调整电源供电策略。这种动态调整可以确保设备在不同负载情况下都能实现最佳的能耗效率。电路设计上,减少功耗消耗点、降低开关频率、优化排布等方式也能显著减少设备在运行时的电路能耗。

最后

人工智能带来的能源问题不仅限于电力消耗,还涉及到大量的水资源消耗和碳排放。国际能源署的数据显示,全球数据中心的电力消耗大约占全球总用电量的1%至1.5%,除此之外还伴随着巨大的碳排放和数百万加仑淡水的消耗。

尽管我们不愿接受,但人工智能正逐渐成为能源密集型行业,这一事实引起了人们的广泛关注。为了避免能源危机和环境问题成为AI发展的必然,业界必须采取积极的措施,未雨绸缪才能赢得未来的双赢局面。

文/陈徐毅 高级工程师,科技专栏作者,中国计算机学会会员。本文刊发于《中关村》第254期