OpenAI近日发布了新一代ChatGPT-O1,一夜之间,国内互联网的各个角落似乎都在为其欢呼。有不少博主发布视频或文章,称美国公司发布了有史以来最强大的人工智能GPT-O1,达到了人类博士专家的水平,顺带还提一下“我们的差距又被拉大了”。

其实,老陈看得这些通稿文章或视频,感受到的依旧是那大洋彼岸熟悉的味道、熟悉的节奏,老陈不得不想问问:ChatGPT-O1真像他们吹的那么好?是否又一轮的舆论战悄然拉开序幕了?这背后的真相是什么?

说GPT-O1已经具备类似人类的推理能力,大模型已经达到人类博士水平,这个话也只能听听。严格来说GPT-O1推理能力变强了,但仍然存在缺陷性和局限性,比如,很多人测试了,问它:9.11和9.8哪个大?得到的答案依旧是GPT-4O曾经给出的错误答案:9.11比9.8大。而且,还整整思考了6秒钟,有时甚至10秒。

不难看出,GPT-O1目前也是没有数的概念,而这样的反应速度和处理能力,真的足以证明它超越了人类博士吗?显然,这背后的逻辑并不严谨。

有博主进一步测试了GPT-O1,给出一个小学数学题:两人在桥上相向而行,两次相遇,求两人行走的总距离。理论上,这应是三倍桥长,但GPT-O1却给出了两倍桥长的错误答案。这样的回答准确性,确实让人不对“史上最强大人工智能”的称号产生质疑。

不过,新一代O1也确实有自己的强大之处。也许是因为堆了算力,它在回答问题之前,会用更多时间去“思考问题”,再去回答问题。也许,通过大模型的训练,它们可能学会完善思维过程,学会自主识别错误。这个能力,或者说是OpenAI宣称的能力,是目前市面上的大模型不具备的。

事实上,这些都要归功于“强化学习”的算法立了大功。OpenAI研究员也是提出CoT的开发者Jason Wei表示,GPT-O1不是纯粹地通过提示完成CoT,而是使用RL训练模型,最终更好地执行链式思考。也就说,chatGPT-o1的做法本质上是让大模型COT自动化,或许已经拥有了一定通用推理能力。

但是,它还需要更多的强化学习和更多的思考时间投入,才能达到更高的水平,或许,那时再提什么超过人类博士了,更有说服力。

其实,你要是独自吹嘘chatGPT-o1,我也不用写这篇文章,还费脑子。也就是总出现一批反思怪,让我们自己反思不足,反思为什么追不上别人“高大上”的技术等等,让人看着生厌。

那你又知道中国的AI到底怎么样了么?即便当下我们购买不到英伟达的超强算力,也阻止不了我们AI技术的发展。无论是学术研究、技术专利,还是人才培养,我们在AI领域里都是顶尖的。像这类有据可查的数据,我此前的文章中介绍过,又想了解的可以翻看我以前文章,不多费口舌。

另外,谈及人工智能的三大基石——算法、算力和数据,GPT-O1在算力上的过度消耗也很引人注目。通过强化学习的方式,迫使GPT-4进行更细致的推理,虽然看似提高了思考深度,但实际上却是以牺牲响应速度为代价。这种“拖延战术”并未让AI变得更聪明,反而让人质疑其效率与实用性。

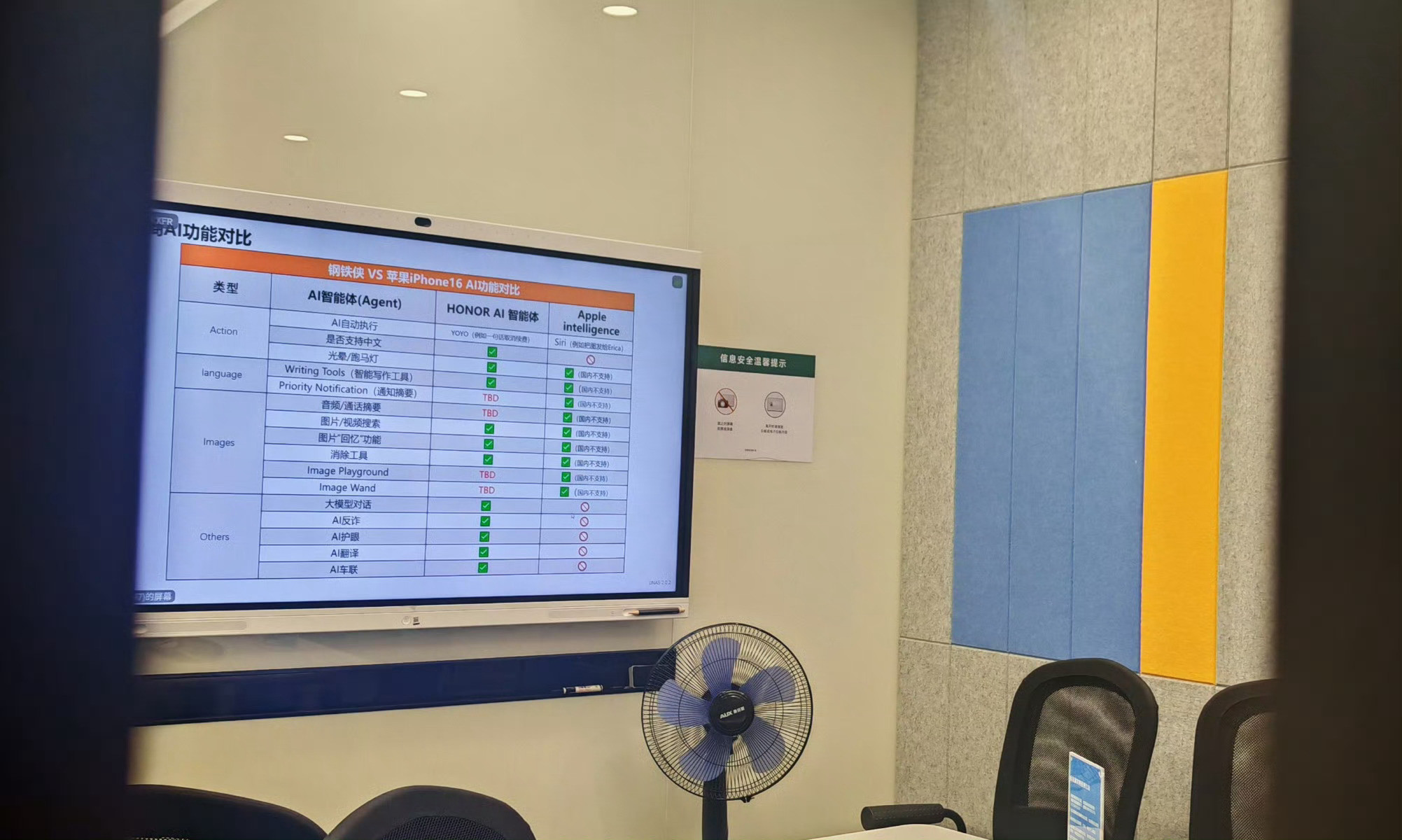

这一点其实大家可以去做个对比,把上面两个同样的问题抛给国产人工智能时,它们却能轻松给出正确答案。但是,这能说明0我们的国产AI已经悄然超越了所谓的“史上最强大”?显然,评价一个人工智能系统的优劣,不能仅凭一两个表面光鲜的案例,而需要全面考察其在实际应用中的表现。

其实,我们在数据积累方面已显露出明显优势。在算法和算力上,我们同样不乏创新与突破。因此,简单地将GPT-O1的某些表现视为人工智能的新里程碑,还让我们自己反思比不过人家,显然有失偏颇。

如果大家在深入分析,你或许能看见GPT-O1的发布背后,或许隐藏着美国为应对芯片市场低迷而采取的策略。随着英伟达等芯片巨头股价的下跌,美国急需通过提升人工智能对算力的需求来刺激市场。于是,他们便利用强化学习的老套路,对GPT-4进行改造,从而诞生了GPT-O1。

仔细想想,这些举动像不像是一场精心策划的营销手段,而非技术上的革命性突破?也许对于“跪族”来看,根本不会是这回事,也许,他们就是觉得人家远远超越、遥遥领先了,并认为我们就是需要反思。因为,这是“跪族”的人格特征。

我们还是要理性看待GPT-O1,不是盲目崇拜或一味贬低,而是平等、尊重地对待每一个新技术的出现。GPT-O1是比前几代优秀,值得我们去学习,也许需要我们去正视与别人存在的差距。但并不代表国产AI大模型没有优势,需要被“跪族”指指点点,我们自身在数据积累和技术创新上的优势,也很大。

对此,大家这么看呢?欢迎大家留言讨论。