DeepSeek风暴卷起,“特斯拉们”会被颠覆吗?(上)

摘自 邱锴俊 电动汽车观察家

踢破算力门槛?

1月27日,英伟达股价大跌16.97%。

因为,DeepSeek告诉了全世界,AI行业也许并不需要这么多的算力。

DeepSeek在2024年年底发布了报告《DeepSeek-V3 Technical Report》,“自曝”其模型的技术架构。

DeepSeek开宗明义,直言公司追求模型高性能、低成本。因此,DeepSeek-V3采用多头潜在注意力(MLA:Multi-head Latent Attention)进行高效推理,区别于传统的多头注意力模型(MHA:Multi-head Attention),从而降低了内存占用并提高了计算效率。

同时,DeepSeek采用了混合专家模型(MoE:mixture of experts)——由多个专业化的子模型(即“专家”)组合而成,每一个“专家”都在其擅长的领域内做出贡献。为了分配“任务”,DeepSeek还设置了“门控网络”的机制。这使得每一个任务不需要展开总体的模型计算,而只要调用子模型就行。

更值得智驾开发者注意的是,为了实现经济高效的训练,DeepSeek采用了FP8混合精度训练,并对训练框架进行了全面优化。

所谓FP8,是指浮点计算的精度。相对于FP32、FP16,FP8精度要低得多,但是计算和存储成本要低很多,计算效率和性能就高。

但是,DeepSeek也不是全数采用FP8计算,而是在关键数据计算时,依旧采用FP32计算,因此称为混合精度计算方式,保证了最终计算结果的准确性。

通过这种混合精度计算方式,DeepSeek实现了加速训练和减少GPU内存使用。

除此之外,DeepSeek还开发了其他的技术,这些举措结合起来,DeepSeek团队就实现了很高的训练效率。

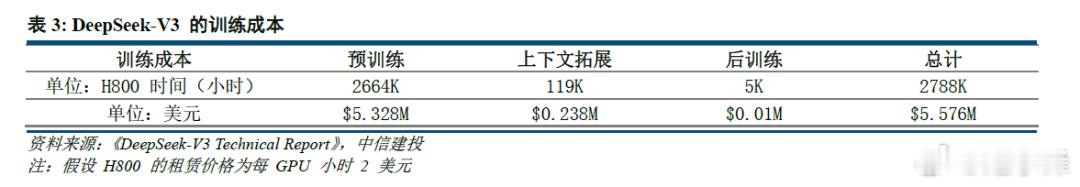

DeepSeek对外表示,DeepSeek-V3的训练成本,只有557万美元,相当于278.8万小时H800GPU的训练量。

当然,这个成本仅包括DeepSeek-V3的训练成本,不包括前期预训练等等。但是,这个成本已经非常低。OpenAI训练GPT-4的成本超过1亿美元。

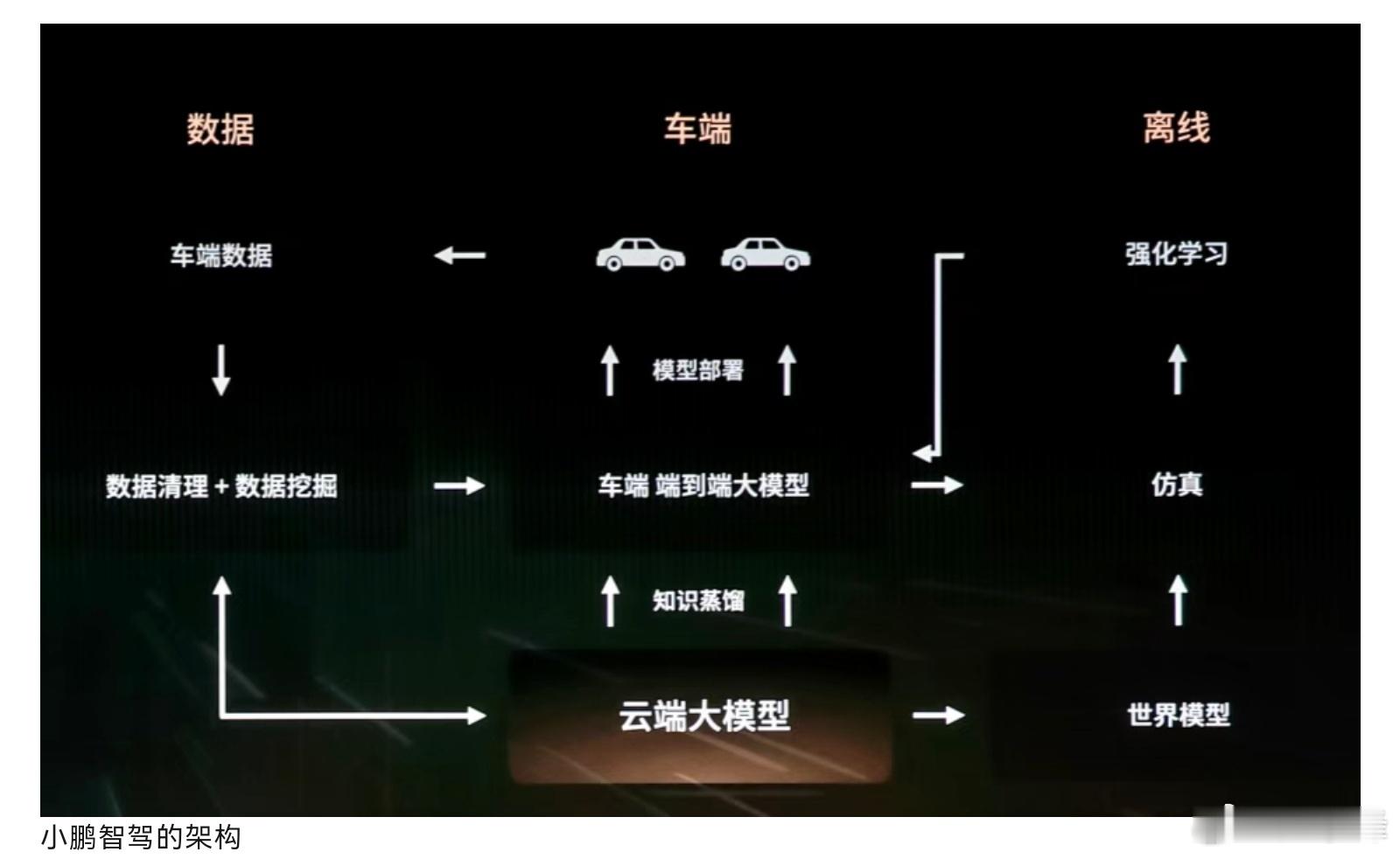

此外,DeepSeek还基于通用模型V3,采用动态蒸馏技术,推出了推理模型R1。

这一点,和智驾企业将云端大模型蒸馏为小模型,从而部署到几百tops算力的车端上,原理上一致。

这就是DeepSeek高效利用算力的奥秘。

不过,也有人认为,DeepSeek算力作弊,甚至国外分析机构认为,DeepSeek其实有1万张H800 、1万张H100、1万张A100和3万张A20芯片,4年总算力成本高达25亿美金。

国内的同业者猜测,DeepSeek仅有万余张芯片。

但总体而言,更为广泛的意见是,DeepSeek V3的在算力应用上,打破了AI行业的算力迷信,也表明AI大模型训练恐怕不需要数十亿美金的投入。

OpenAI创始成员Andrej Karpathy就说,DeepSeek V3让在有限算力预算上进行模型预训练这件事变得容易。

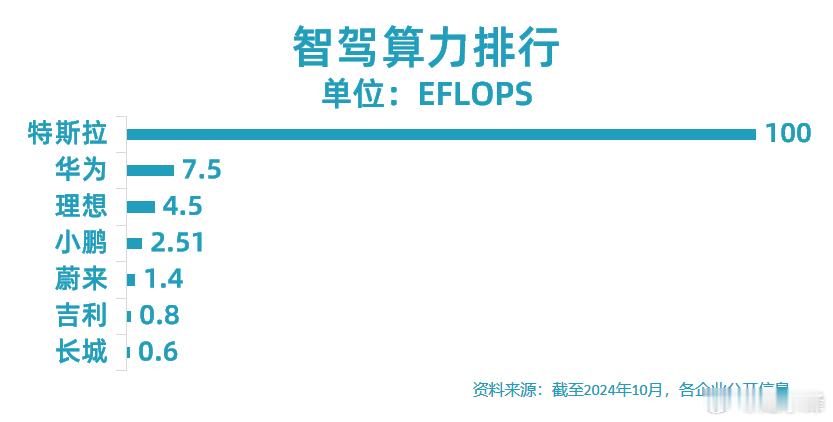

但如今,智驾企业正在进行算力竞赛。DeepSeek一系列提升计算效率,降低模型训练成本的方法,如果援用到智驾模型训练中,同样将降低对算力的需求。这是否会让更多企业加速进入到智驾自研开发当中呢?

也有人认为不会。

FutureLabs未来实验室首席专家胡延平就表示,(DeepSeek之后)“由此颠覆了模型与算力关系更说不上。

他说,接下来大家会越来越清楚地看到,这个领域有捷径但没有弯道超车,有后发成本优势但没有后发领先优势,AGI路线更是只能取巧没有投机。比如即使L3+级别的智能驾驶,端到端向VLA进化,车辆SoC算力1000TOPS起才勉强可玩,2000-3000TOPS会稀松平常,即使如此,短期内也未必能够到真正的L4。向上曲线的模型思考长度速度整体度、多模态、感知思考与行为能力合一等方向,只可能将算力需求拉升到新高度。向下曲线对成本效率有改变,但对捧得AGI圣杯的贡献可以忽略。”

当然,他说的是车端模型。云端大模型能否用更少算力训练出来?DeePSeeK告诉我们,不要轻易说不。