读了一下Oriol Vinyals 所说的「蒸馏法」最早的一篇论文,即发布于 2015年的 Distilling the Knowledg in a Neural Network

发现信息量其实比预想的要大:

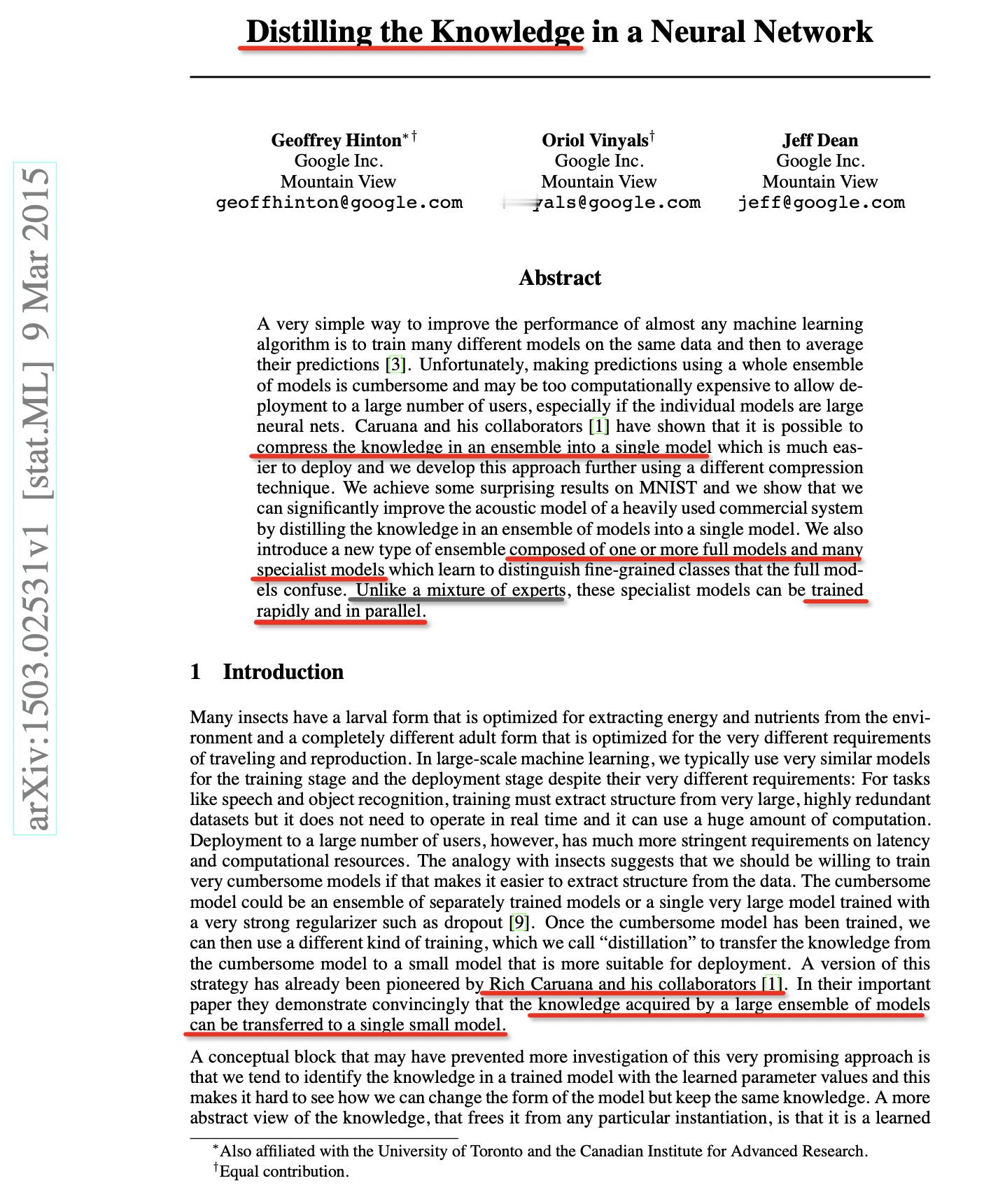

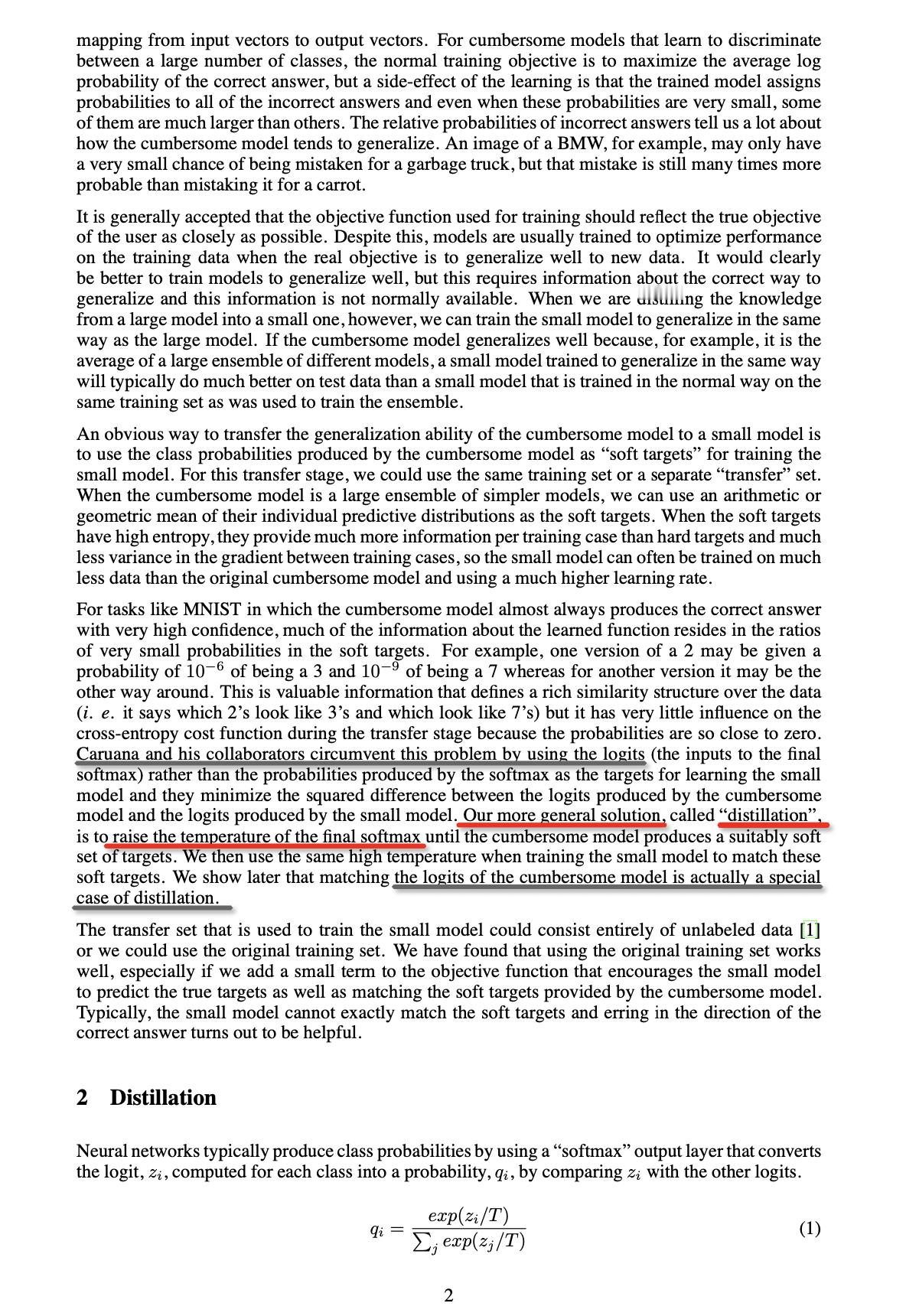

1. 其实此论文是对 2006 年的一篇论文 Models Compression 的一般化,即采用了一个温度参数来作为 softmax,而 Models Compression 就是其特例,即 T = 1

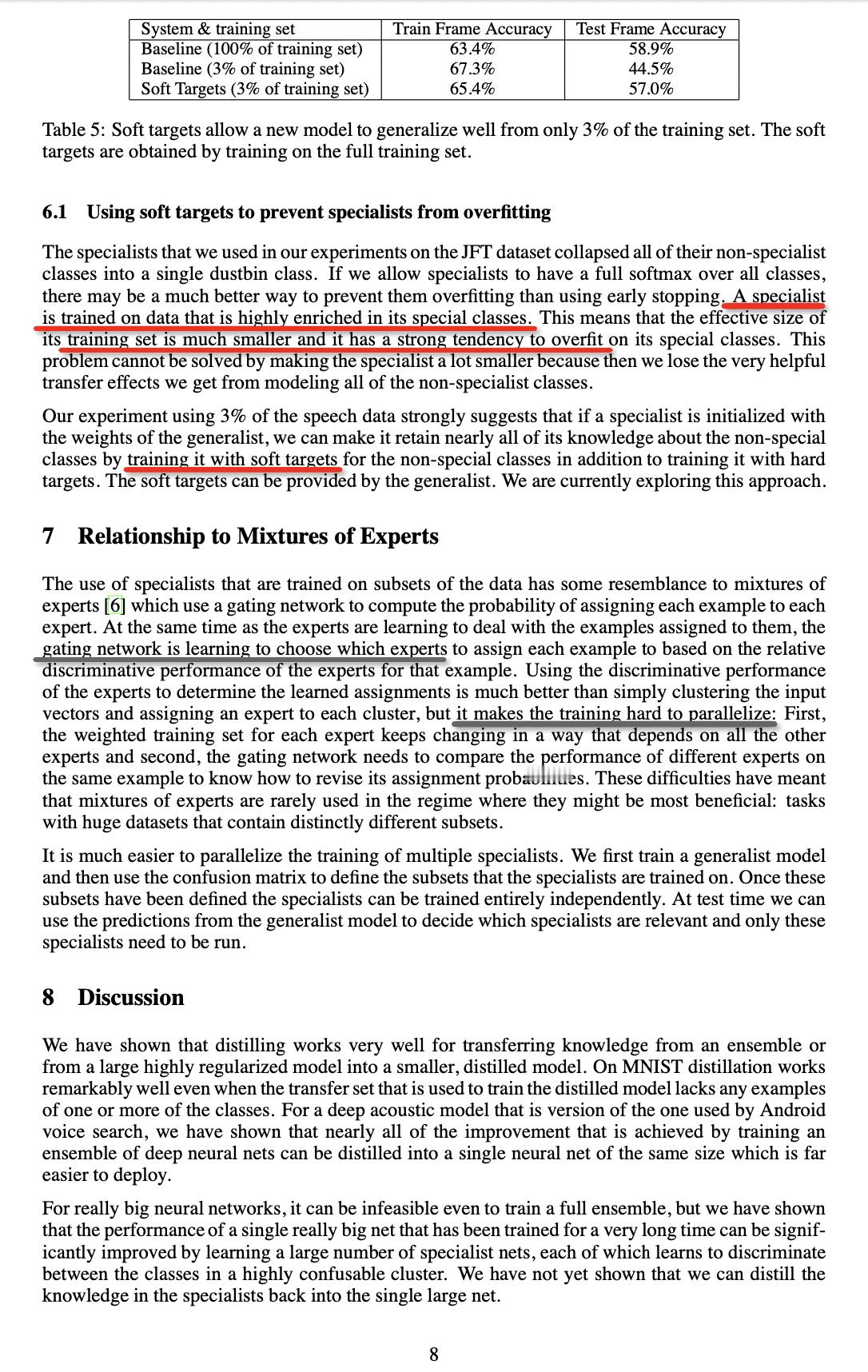

2. 无论此论文还是 Models Compression 都认为这是一种知识压缩方法,compress the knowledge in an ensemble into a single model

有意思吧?但是好像现在搞神经网络的人都不清楚这个概念。其实他们在做的本质就是在寻找一个更紧凑的压缩模型来接近无损的存储信息

3. 论文中明确提到了,当 T 介于 2.5 和 4 之间的时候,会获得最佳的效果,而且还指出(图三)

诸位,这就非常有意思了

这可能表明蒸馏法的这个温度很可能等价于条件概率组合的数量,即我们所说的进制,理论上自然数 e,即 2.718... 会是最佳的

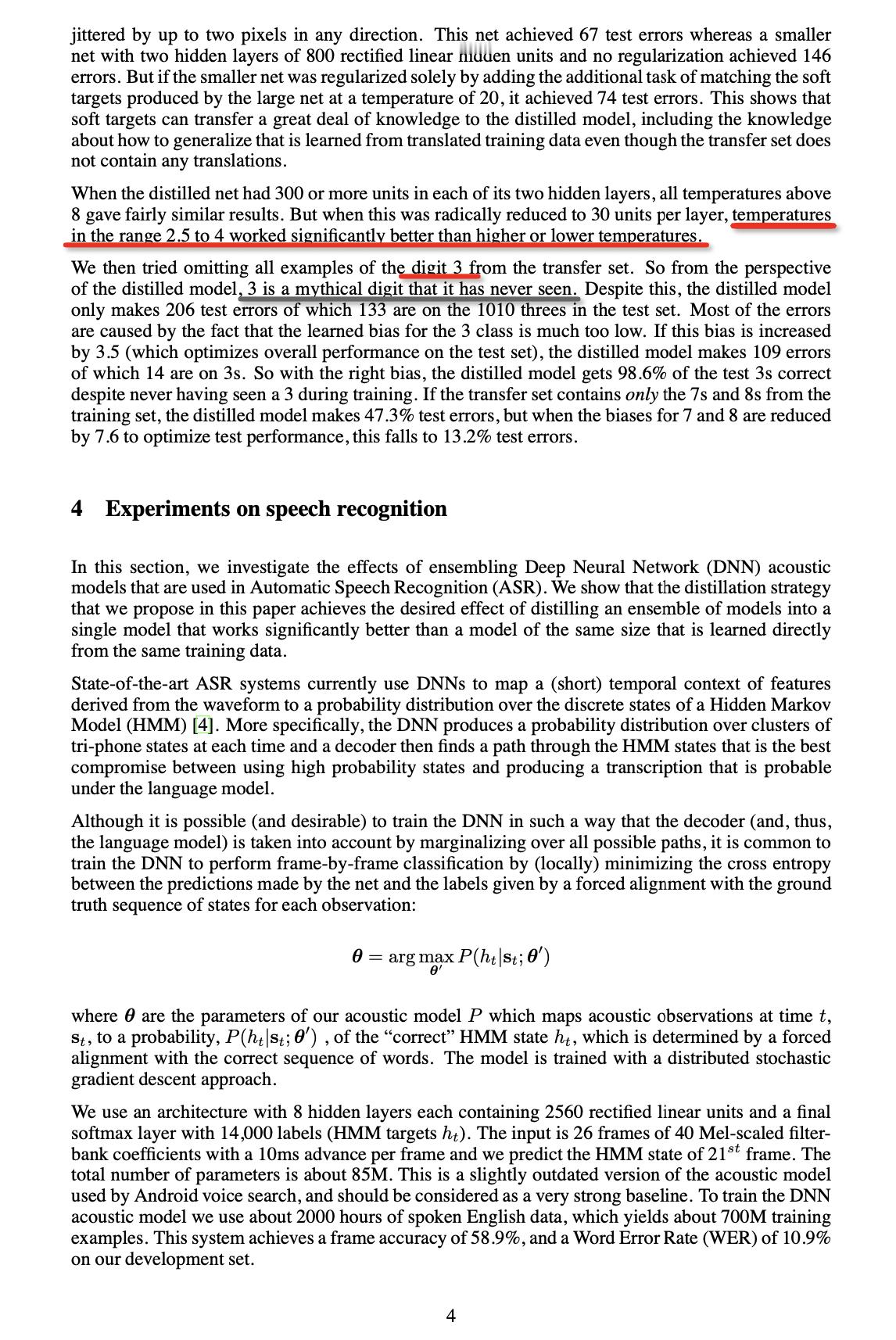

4. 此论文其实不止提出了蒸馏法,还提出了可以并行训练,提高训练速度的方法,而且明确指出, Mixture of Experts MoE 是做不到并行训练的

总之,此论文其实应该算是 Models Compression 的一般化方法,并且其理论体现发恰恰正是信息论的熵理论,只是这两个论文之间相差了 10 年,而且现在搞人工智能人普遍不知道信息论

.